ビッグデータ分析がビジネスの勝敗を分ける──カギはデータサイエンティストの育成:ITmedia エグゼクティブセミナーリポート(2/2 ページ)

アナリティクスとは多様化するデータをいかに取り扱うか。従来型の構造化された企業データはもちろん、ソーシャルメディアの情報や各種センサー情報、位置や地図の情報、画像、動画など急増する非構造化データを、いかに有効活用するかが重要だ。

Google Glassは、米Googleが開発したヘッドマウントディスプレイ方式の拡張現実ウェアラブルコンピュータである。自然言語による音声コマンドなどを利用して、ハンズフリーで操作したり、情報を表示したりすることができる。アクセンチュアではPhillips社と共同で、このGoogle Glassに、患者の電子カルテ情報を表示して、迅速かつ効果的な治療に生かすなど、医療現場で利用する実証実験に取り組んでいる。

また、導線分析を活用すれば、例えば大勢の人が町中を移動した4億件以上の地理空間情報から、「隠れマルコフモデル」と呼ばれる統計モデルを利用して、意味のある、特定の人の動きをだけを抽出し、その情報を地図上に展開することで新たな知見を創出することができる。この事例は、テレビの情報番組でも紹介されており、11月にはWire&Wirelessと共同開発したサービスも発表している。

さらに将来的には、予防的医療決定支援システムを活用して、外来予約から往診・問診、予防医療、検査・連携、処方箋までの医療情報連携による医療の質の向上と病院の効率的経営に貢献することが期待されている。

OSSで小さくはじめて大きく育てる

ビッグデータは、何ができるかよく分からないので、初期投資をあまりしたくないという声をよく聞く。そこで注目されているのが、オープンソースソフトウェア(OSS)の利用である。工藤氏は、「OSSを利用して、まずはビッグデータで何ができるのかをクイックに見せることが有効になる」と話す。

ビッグデータ分析の導入ステップの一例として、まずはクラウド環境にClouderaのCDH(Cloudera's Distribution Including Apache Hadoop)を導入し、ビッグデータ分析のPOC(Proof of Concept)を実施する。次にクラウド環境をオンプレミス環境に移行して、本番運用を開始。Apache Flumeなどの活用により、処理のリアルタイム化を実現する。

ビッグデータ分析を実現するためには、その手前にある膨大なデータの前処理も重要になる。工藤氏は、「データを抽出し、加工する作業は、モデル構築の中で最も負荷が高く十分な要員の配置と支援体制が重要になる。あるプロジェクトでは、データ探索の作業が14営業日であったのに対し、データの抽出・加工は32営業日必要だった」と話す。

このプロジェクトでは、特にETL(Extract:抽出、Transform:変換、Load:ロード)ツールの独自開発に時間を割いたという。工藤氏は、次のように語る。「データサイエンティストという職種は、聞こえは良いが、最初にこうしたドロドロした作業があるということも理解しておかなければならない」

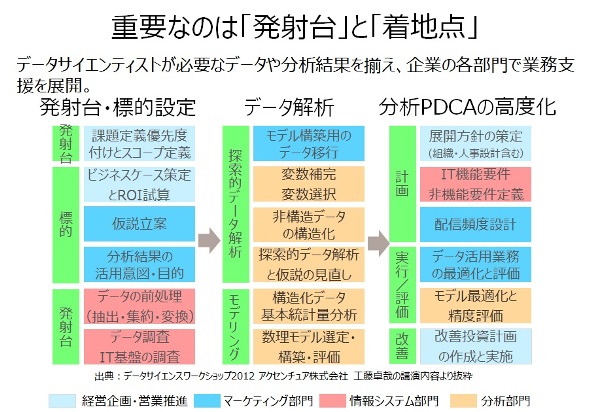

前処理の次に重要になるのが「発射台」と「着地点」を明確にすることである。工藤氏は、「ビッグデータ分析といっても、伊豆諸島まで旅行をしたいのか、ロケットを月に飛ばしたいのか、目的が明確でなければ、どれだけの準備をすればよいかが分からない。またロケットを飛ばす場合、地面がぬかるんでいるとうまく飛ばすことができない」と話す。

つまり経営課題や分析の処理基盤、データの品質などを考慮せずに分析しても、期待した結果を得ることはできないということである。工藤氏は、「ゴミを入れるとゴミが出てくるというたとえがあるように、どれだけお金をかけても、入口が悪ければ、正しい出口にたどり着くことができない。そこで、発射台と着地点が重要になる」と言う。

工藤氏は、「企業からデータサイエンス部門を立ち上げたいという話をよく聞くが、データサイエンス部門を立ち上げるためには、経営企画・営業推進、マーケティング部門、情報システム部門、分析部門など、非常に多くの部門が関わり、チームワークを発揮しなければ実現できない。アクセンチュアでは、こうした企業を今後も支援していく」と話し、講演を終えた。

関連キーワード

ビッグデータ | 医療 | アクセンチュア | データサイエンティスト | Google | オープンソース | 個人情報保護 | ウェアラブルコンピュータ | ソーシャルメディア | 情報システム部門 | 非構造化データ | ITmedia エグゼクティブセミナーリポート | 共同開発 | 位置情報

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

- グローバル革命が製造業を革新――高度な経営のかじ取りが求められる今後の製造業

- グローバリゼーション3.0――高度な経営のかじ取りが求められる製造業をITで支援

- 攻撃されないサーバはない!――進化するサイバー攻撃から学ぶセキュリティ対策

- まず敵を知ること――事象から考えるサイバーセキュリティ対策のあり方

- サイバー攻撃から学ぶIT経営時代のセキュリティ対策

- 標準化によって少子高齢化や災害医療の課題に立ち向かう「コンティニュア」の取り組み

- M2Mで日本が世界に先駆けるために必要な「視点」と「戦略」

- モバイル活用で流通業界に新風――日本の「おもてなし」をアジアへ

- イノベーションを生み出すネットワーク組織の推進にモバイルは不可欠