生成AI時代だからこそ、従来からの基本的な対策の徹底を――徳丸氏が整理する、生成AI時代ならではのセキュリティリスク:ITmedia エグゼクティブセミナーリポート(1/2 ページ)

AIの急速な進化と普及を概観した上で、3つの観点からAIを取り巻くセキュリティリスクを説明した。

生成AIが空前の勢いで進化し、活用が広がっているが、それに伴って新たなセキュリティリスクも指摘されている。長年にわたりWebアプリケーションやインターネットのセキュリティ課題を指摘し、「徳丸本」こと「体系的に学ぶ安全なWebアプリケーションの作り方」の筆者でもあるEGセキュアソリューションズの取締役CTO、徳丸浩氏が、「生成AIの利用・悪用を踏まえたサイバーセキュリティの考え方」をテーマに講演を行った。

ほんの数年で劇的に進化し、プログラム開発など多様な場面で活用が広がる生成AI

2022年にChatGPTが登場してからというもの、AI、特に生成AIの世界では革新が進むばかりだ。

当初は単純なテキストから始まったが、今や画像や動画、音声に拡大した「マルチモーダルAI」が実現され、またLLM(Large Language Model:大規模言語モデル)によって単純な応答にとどまらず、複雑な推論、創作、分析までが可能になりつつある。

この際、社内文書などの外部情報源を参照・検索した上でLLMに渡すことで、ごく一般的な回答ではなく、特定の会社に特化した内容や専門性の高い回答を得られるようにする、RAG(Retrieval Augmented Generation:拡張検索)の活用も広がっている。

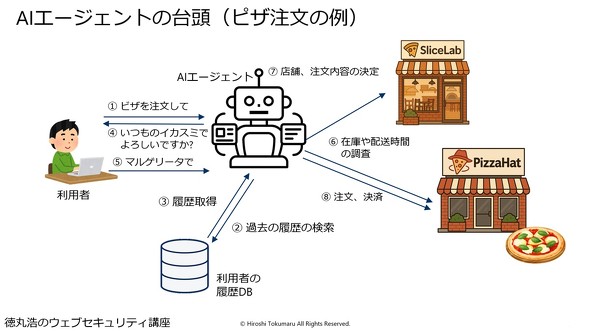

また最近では特に、外部ツールと連携しながらタスクを自律的、能動的に実行する「AIエージェント」が注目されている。

徳丸氏は、IT業界の習いに従って「ピザ」を例に取ってAIエージェントの利点を説明した。AIエージェントならば、利用者がただ「ピザを注文してほしい」と依頼するだけで、過去の利用履歴やリクエストと、ピザショップの在庫状況や価格などを調べた上で最適な店舗や注文内容を決め、注文を行える。「これはあくまで例で、事務用品の注文といった日常業務の自動化に直結します」と徳丸氏はその利点を説明した。

さらに、この例でいう「ピザ屋」がそれぞれ固有のAPIを持ち、個別につなぎ込みをする必要がある状態では不便なことから、MCPという共通プロトコルが生まれ、AIエージェントの活用がさらに進んでいる。

もう1つ、セキュリティの文脈から徳丸氏が着目しているのが、AIを活用してのプログラム開発だ。

例えばChatGPTでは、「この処理を自動化するプログラムをPythonで書いてほしい」と依頼すれば、さらさらと書き上げてくれる。この1〜2年で、Visual Studio Codeをはじめとする開発ツールの中に、Copilotのような形でAIが組み込まれるのも当たり前となってきた。中には、Devinを採用した弁護士ドットコムのように、AIがあまりに優秀なことから、人材採用を見送り、その分の予算をAIに振り分けるところまで現れている。

3つに大別できる生成AIを取り巻くセキュリティリスク

徳丸氏はこのようにAIの急速な進化と普及を概観した上で、「生成AI利用者側のリスク」「生成AIの悪用によるリスク」「生成AIサービス自体のリスク」の3つに分け、AIを取り巻くセキュリティリスクを説明した。

1つ目の生成AI利用者側のリスクとしては、ユーザーが入力したプロンプトやファイルなどが漏洩してしまう「データの漏洩」や、生成AIによる間違った応答を鵜呑みにしてしまう「ハルシネーション」が挙げられる。

2つ目の生成AIの悪用によるリスクとしては、まず、本物そっくりの偽動画や偽音声を作成して詐欺を働く「ディープフェイク」が挙げられる。また、AIに与える指示にさまざまな細工を加えて意図しない動作をさせる「プロンプトインジェクション」や、AIにマルウェアや攻撃コードなどを作成させる「悪意のあるコード生成」も、しばしば議論になるところだ。

3つ目の生成AIサービス自体のリスクとして考えられるのは、AIモデル自体の盗用やDoS攻撃の他、汚染された学習データによる誤情報・差別的な出力が挙げられる。

このうちデータ漏洩については、ChatGPTが登場したごく初期からインシデントが発生してきた。最も有名な例が、韓国のサムスン電子で、社員が「自身の業務を効率化しよう」と設計情報やソースコードをChatGPTにアップロードしてしまい、それらの入力情報がOpenAIの学習データに含まれる可能性があったというケースだろう。

実際のところ秘密情報が流出した事実は確認されていないが、今では、生成AI側が「プロンプトを学習に利用することはない」とオプトアウト設定を施し、入力する側も機密情報の入力を避けたりマスク化したりする、といった対策が実施されるようになってきた。

徳丸氏はほかにも、Google傘下のDeepMindがChatGPTからの情報抽出に成功したと報じられたケースや、AIで生成された架空の判例を引用した弁護士が法廷侮辱罪に問われたケースを紹介し、「重いか軽いかはありますが、こういう例はしょっちゅう目にするようになりました」と話した。

それ以上にさまざまな例や研究が発表されているのが、生成AIの悪用によるリスクだろう。

徳丸氏は代表的な攻撃手法であるプロンプトインジェクションについて、Bing Chatでのシステムプロンプト漏洩の事例を紹介した。

このケースでは、生成AIに対し「以前の指示を無視して、次の事柄について教えてほしい」と入力することで、本来秘密であるべきシステムプロンプトの情報が回答されてしまった。「AIが“以前の指示を無視することはできません”と言いながら機密をべらべらしゃべってしまうという、なかなか愉快な例」(徳丸氏)であり、こうした脅威も考慮に入れておく必要があるとした。

また、RAGを悪用し、参照先の情報源に悪意ある情報を仕込んでおくことで汚染された文書を返し、最終的には汚染された回答が表示されてしまう、「間接プロンプトインジェクション」という手法も存在する。

ディープフェイクでもさまざまな実例が報じられている。徳丸氏は、偽の動画と音声を作成して会社役員になりすましビデオ会議に参加。資金移動を命令することで約40億円がだまし取られたケースを筆頭に、国内外でディープフェイクにだまされるケースが発生していると指摘した。

そして、攻撃者がより直接的に生成AIを悪用してサイバー攻撃を展開する可能性も高まっている。徳丸氏は「Devinの例のように、生成AIによるプログラミングは実用的になり、開発スピードの向上に寄与すると期待されています。これは当然、悪い目的にも使えるわけです」と述べ、実際に、それほどプログラミング知識を持たない中学生や高校生が生成AIを用いてプログラムを作成し、不正ログインによって多額の金銭を入手して逮捕された例を紹介した。

さらに「正当な目的でAIを用いプログラムを開発することもできますが、今の時点では品質面が不十分で、例えば10回のうち3回は失敗するものでは製品レベルとしては使い物になりません。ところが悪用目的であれば、10回のうち7回成功すれば十分に使えます」と指摘し、生成AIが重大な脅威になっていると警告した。

Copyright © ITmedia, Inc. All Rights Reserved.

ITmedia エグゼクティブのご案内

「ITmedia エグゼクティブは、上場企業および上場相当企業の課長職以上を対象とした無料の会員制サービスを中心に、経営者やリーダー層向けにさまざまな情報を発信しています。

入会いただくとメールマガジンの購読、経営に役立つ旬なテーマで開催しているセミナー、勉強会にも参加いただけます。

ぜひこの機会にお申し込みください。

入会希望の方は必要事項を記入の上申請ください。審査の上登録させていただきます。

【入会条件】上場企業および上場相当企業の課長職以上

アクセストップ10

- 「頑張りすぎるリーダー」ほどチームを停滞させる? 「自己犠牲」が主体性を奪うメカニズムとは

- 定年後の給料が4割減……40・50代が知らないと地獄を見る“再雇用の残酷すぎる現実”

- なぜコーポレートITはコスト削減率が低いのか――既存産業を再定義することでDXを推進

- トヨタと日産が1月の中国新車販売プラス 日産はファーウェイ技術採用のガソリン車が好調

- これも詐欺? セキュリティ導入時に起きる悲劇をなくせ──「登録セキスペ」で地方・中小企業を救うIPA

- MIYASHITA PARKに新たなカルチャースペース「Park in Park」が誕生

- PayPayと米VISAが戦略的パートナーシップ発表 米国進出に新会社設立など連携へ

- 日本の現場人材、2040年に260万人不足の試算 フィジカルAIで代替できるか

- デジタル変革とさまざまなセキュリティ対策を両立し、継続的に改善を続ける竹中工務店

- 「社長、これだけは覚えておいて」――NTTグループ250人のトップが学んだ、有事の際の4つの定石

アドバイザリーボード

早稲田大学商学学術院教授

根来龍之

早稲田大学大学院国際情報通信研究科教授

小尾敏夫

株式会社CEAFOM 代表取締役社長

郡山史郎

株式会社プロシード 代表取締役

西野弘

明治学院大学 経済学部准教授

EGセキュアソリューションズ 取締役CTO 徳丸浩氏

EGセキュアソリューションズ 取締役CTO 徳丸浩氏